포스팅 개요

이번 포스팅은 추천 시스템(recommender system, recsys) 논문 중 VECF : Personalized Fashion Recommendation with Visual Explanations based on Multimodal Attention Network 이라는 논문을 리뷰라는 포스팅입니다. VECF는 추천 시스템 방법 중 이미지 정보를 활용하며, 하나의 전체 이미지 중 중요한 region을 고려한다는 개념과 더불어 attention을 활용하는 추천 시스템입니다. 본 포스팅은 해당 논문의 전반적인 내용을 리뷰해봅니다.

또한, 본 포스팅은 제가 작성하고 있는 추천 시스템 시리즈 글 입니다. 추천 시스템 시리즈 논문 리뷰는 아래와 같은 순서로 진행할 예정입니다. 오늘은 그 세 번째 포스팅입니다.

- DeepFM (https://lsjsj92.tistory.com/636)

- MAML (https://lsjsj92.tistory.com/637)

- VECF

- FDSA (https://lsjsj92.tistory.com/639)

- PMN (https://lsjsj92.tistory.com/640)

- GAU (https://lsjsj92.tistory.com/641)

- A3NCF (https://lsjsj92.tistory.com/642)

- MIAN (https://lsjsj92.tistory.com/643)

- CCANN (https://lsjsj92.tistory.com/644)

본 포스팅에서 참고한 자료는 다음과 같습니다.

포스팅 본문

추천 시스템 논문 VECF : Personalized Fashion Recommendation with Visual Explanations based on Multimodal Attention Network 논문 리뷰는 다음과 같은 순서로 진행합니다.

1. VECF 핵심 요약

2. VECF 논문 리뷰

VECF 핵심 요약

기존의 Fashion Recommendation

• 하나의 전체 이미지를 fixed-length vector로 변환하여 사용함

• 이는 아래와 같은 한계가 존재

• 사람들은 쇼핑을 할 때 이미지의 몇몇 지역 ( 카라, 손목 등 )을 고려함

• 또한, 이러한 지역은 사용자마다 다름 ( 개개인의 선호도가 있음 )

• Global image embedding은 이런 점을 고려하기 쉽지 않음

• 상관없는 image region까지 무분별하게 encoded 됨

• 이는 많은 노이즈를 일으킴

• Recommendation explainability

• 사용자 쇼핑 경험 향상에 중용함

• 기존 방법은 이러한 사용자 시각적 선호도를 발견하는데 있어 합리적인 시각적 설명을 생성하지 못함

따라서 본 논문은!

• User review information과 product image information을 함께 학습

• 사용자가 이미지 어느쪽에 흥미를 느끼는지 더 정확한 방법을 사용

• pre-segmented image region을 사용하며 attention mechanism을 활용

• 이를 통해 사용자의 시각적 선호도를 반영할 수 있음

• attention 값을 이용해 visually explain이 가능

• 즉, 정확한 추천을 제공할 수 있을 뿐만 아니라 시각적 설명을 할 수 있는 모델을 제안!

VECF 논문 리뷰

VECF : Personalized Fashion Recommendation with Visual Explanations based on Multimodal Attention Network 추천 시스템 논문에 대해서 자세한 리뷰를 진행합니다. 리뷰는 본 논문에서 나와 있는 순서대로 진행합니다.

Introduction

패션 상품을 구매하는 사용자

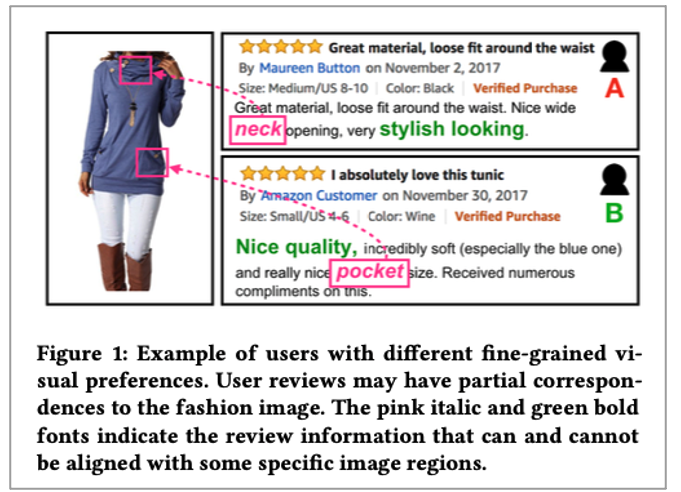

보통 패션 상품을 구매하는 사용자는 이미지를 본 후에 구입하는 특징이 있다고 합니다. 이 때문에 이를 활용하려는 연구도 있었다고 하네요.

기존 연구의 한계

하지만, 기존 연구에는 한계가 있었다고 합니다. 대표적인 것이 사람들은 쇼핑을 할 때 이미지의 몇몇 지역 ( 카라, 손목 등 )을 고려하는데요. 이러한 지역성은 사용자마다 다릅니다. ( 개개인의 선호도가 있기 때문이죠 ) 과거 연구에서 많이 활용된 Global image embedding은 이런 점을 고려하기 쉽지 않다는 단점이 있습니다. 왜냐하면 상관없는 image region까지 무분별하게 encoded 되어많은 노이즈를 일으키게 되기 때문입니다.

또한, Recommendation explainability는 사용자 쇼핑 경험 향상에 중요합니다. 기존 방법은 이러한 사용자 시각적 선호도를 발견하는데 있어 합리적인 시각적 설명을 생성하지 못한다는 단점이 있었습니다.

VECF(Visually Explainable Collaborative Filtering) 모델을 소개함

따라서 본 논문에서는 위와 같은 격차를 해소하기 위해서 더 효과적인 패션 아이템 추천 방법을 소개합니다. 그 방법은 Attention mechanism을 이용해서 valuable image region을 강조하고 noisy 저하시키는 방법입니다. 그리고 세분화된 사용자 선호도를 발견하는데요. 편리하고 매력적이며 효율적인 추천 아이템 선정 가능하고 시각적으로 설명이 가능하다고 합니다.

그러나 여전히 다음과 같은 어려움이 있다고 합니다

1. Less informative supervision signal

• Signal이 sparse하고 less informative하게 나타남 ( 사용자 개개인의 선호도 부분이 )

• 즉, user implicit feedback이 희소하다는 것

2. Difficulties in selecting appropriate image segmentation method

• 이상적인 방법은 object detection 같은 것을 활용해서 semantically하게 region을 나누는 것 ( 목 부위 등 )

• 하지만 패션 카테고리에서 이를 label 하는 것은 쉽지 않음

• 사용자 선호도가 다양하고 변화하기 때문에 통일된 segmentation도 없음

3. Lack of evaluation dataset

• Publicly하게 나온 평가 데이터 셋이 사실상 없음

이런 어려움을 해소하기 위해!

본 논문에서는 위와 같은 어려움을 해소하기 위해서 User review information을 사용했습니다. 이를 통해 model supervision signal을 향상 시킬 수 있었다고 합니다. 왜냐하면 사용자 의견 등은 powerful한 정보이기 때문이죠. 이를 위해 LSTM 모델을 태우는데 visual feature를 word generation process에 넣어줍니다. Different modalities를 효율적으로 결합하기 위해서라고 하네요.

또한, Image는 Small grid로 쪼개어줍니다. 이렇게 함으로써 다양한 세부 정보를 얻을 수 있습니다.

이전 연구와 다르게 본 논문은

• Improve the recommendation performance

• Intuitive visual explanations for the recommended fashion products

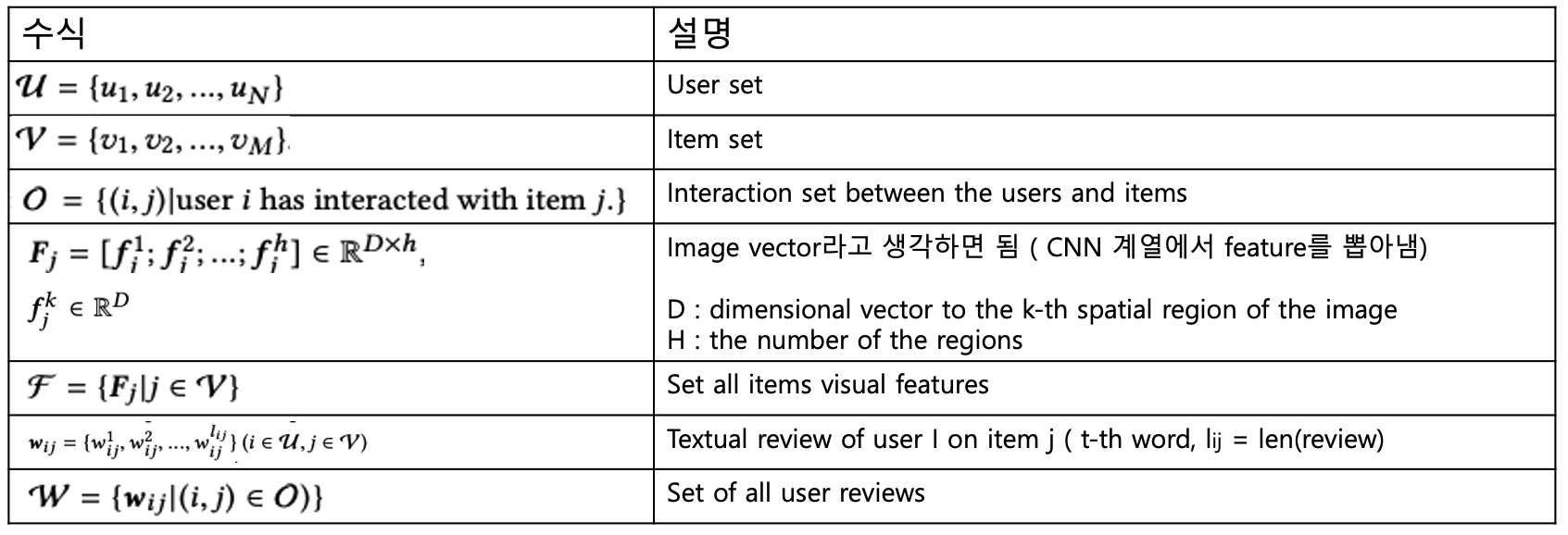

Problem Formulation

The VECF Model - Fine-grained Visual Preference Modeling

본 논문에서 제안하는 추천 시스템 모델은 visual 정보를 활용합니다. 이때 fine-grained visual preference를 모델링하는데요. 본 파트는 이 과정을 설명하는 파트입니다.

Attentively combining pre-extracted region feature

기존 방법 ( image into a fixed vector )과 다르게 영역 특징을 attentively하게 결합하여 본 논문에서는 활용합니다. VGG-19의 conv5 layer 활용해서 feature map을 획득하며 이때의 특징은 총 영역 ( h ) = 196개 ( 14 X 14 )입니다. 따라서 VGG-19에서 나온 512를 이용해 14 X 14 X 512 representation을 얻을 수 있습니다.

Final embedding of item j image는 pooling feature matrix(Fj)로 계산합니다.

Attention weight : 사용자 별로 세분화 된 시각적 선호가 반영 됨!

The VECF Model - Review enhanced Model Supervision

본 논문에서 제안한 추천 시스템은 review 데이터도 활용합니다. 이를 이용해 model의 supervision을 강화합니다.

Text 형태의 리뷰를 활용

text 형태의 리뷰 데이터를 본 논문에서는 활용합니다. 사용자 선호도를 드러내는데 유익하다는 특징이 있죠. ( 같은 제품이어도 사용자마다 선호하는 것이 다르기 때문 ) 따라서, 사용자마다 다른 선호도를 bias하게 추가 모델링할 수 있습니다.

Integrate heterogeneous information가 주된 과제

즉, User review and product image를 통합하는 것이 본 논문에서의 주된 과제입니다. 이를 위해 LSTM Unit을 사용하되 different feature modalities를 결합하기 위해서 Attentive image embedding ( I_ij )를 넣어줌으로써 LSTM을 수정합니다.

The VECF Model - Optimization Objective

본 논문에서 제안하는 모델의 optimization objective에 대한 설명입니다.

마지막 목표는 전체 사용자를 돌면서 이전에 구입한 item set( ν_+^i )과 구입하지 않은 item set (ν / ν_+^i)으로 likeness를 구합니다. 즉, 사용자 implicit feedback을 maximize하는 것이죠. 동시에 current words를 예측하는 것과 regularize term을 두었습니다.

이렇게 함으로써 올바른 아이템을 추천하고 + visual explanation ( attention weights 이용 ) 가능하도록 하였습니다.

Experiments

4개의 research question에 focusing함

본 논문에서는 아래와 같이 4가지 question에 focus하여 실험 및 연구를 진행하였습니다.

1. 다른 SOTA 모델과 비교해서 성능을 향상시킬 수 있는가?

2. hyper-parameter에 따른 성능

3. 다른 모델 컴포넌트의 영향

4. visual explanations이 타당한 결과가 나오는지

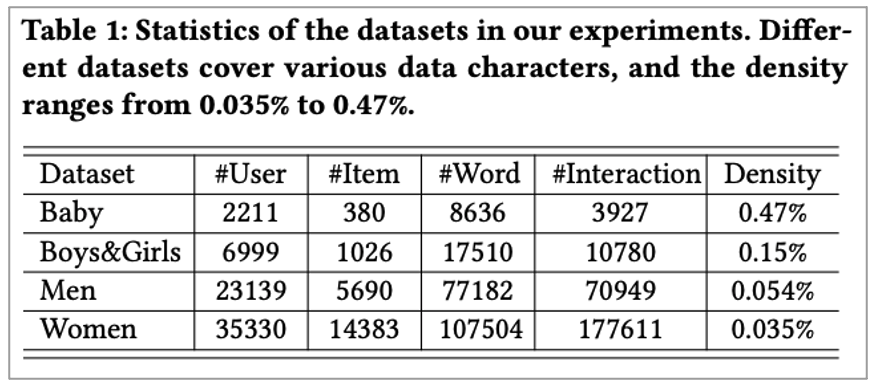

Dataset

본 논문에서 사용한 데이터 셋은 Amazon 데이터를 사용하였습니다. 그리고 이 데이터 셋을 4개의 subset으로 나누었습니다.

Baseline

본 논문에서 사용한 baseline 모델은 다음과 같습니다.

• BPR

• VBPR

• NRT

• NFM++

RQ1 ( Top-N Recommendation )

먼저 첫 번째 실험 결과 입니다. 첫 번째 실험은 다른 SOTA 모델 대비 성능이 나오는지 확인합니다.

실험 결과를 살펴보면 User review나 product image를 결합한 VBPR, NRT는 BPR보다 좋은 성능을 보여줍니다. 이는 추가 콘텐츠를 제공할 수 있는 정보의 효과를 검증한 것이죠. 또한, NFM++은 좋은 성능을 보여줬습니다. 여기서 얻을 수 있는 직관은 모델 자체가 많은 정보를 이용해 user profiling을 assist 하였다는 것입니다. 그러나 이러한 것들보다도 VECF가 더 좋은 성능을 나타내주었습니다.

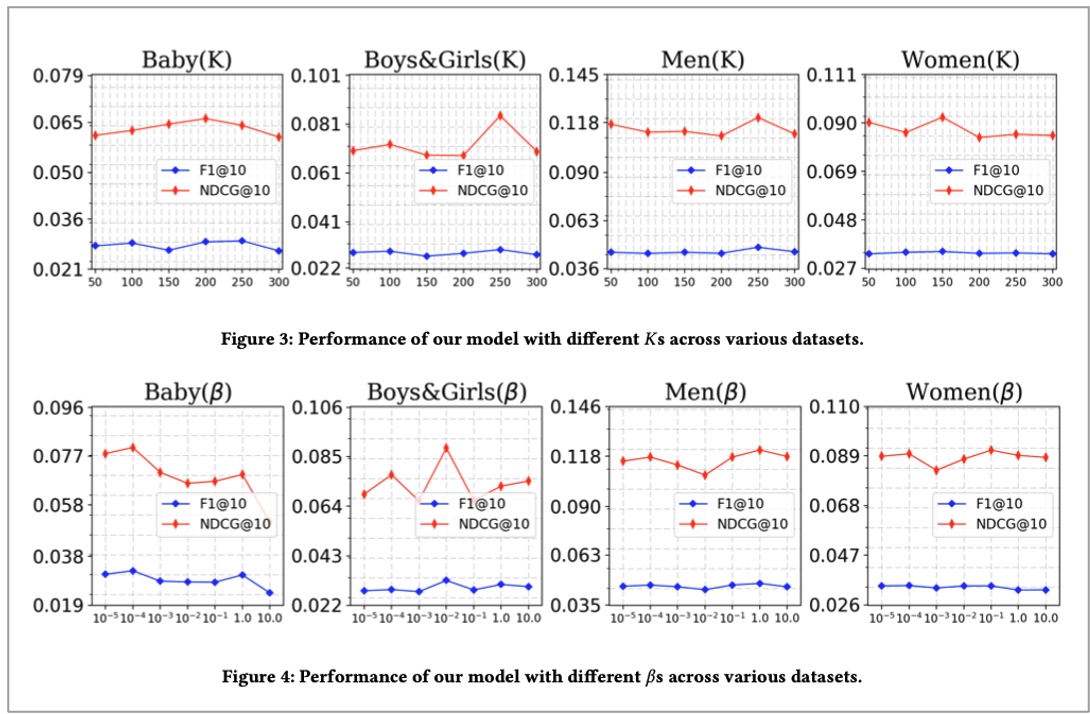

RQ2 ( Parameter analysis )

본 논문에서 진행한 두 번째 실험 파라미터에 따른 성능 평가입니다. K가 크면 overfitting 경향을 보였으며 β 는 trade off한 모습을 보였다고 합니다. implicit feedback과 user review information에서 β는 dataset마다 다르게 나타났으며 이는 도메인 의존성의 모습을 보여줬다고 하네요. 그리고 큰 β 는 too much on review information하였으며 큰 β 는 성능이 좋지 않은 모습을 보여줬다고 합니다.

RQ3 ( Model Ablation Study )

세 번째 실험인 모델 컴포넌트 영향을 위해 다양한 ablation study를 진행하였습니다. 여기서 실험한 모델은 다음과 같습니다

• VECF ( 제안 모델 )

• VECF(-rev) : remove user review information

• VECF(-att) : drop attention mechanism ( Directly average all the regional features )

그 결과를 살펴보니 VECF가 일관성 있게 성능이 좋았다고 합니다.

RQ4 ( Evaluation of Visual Explanations )

마지막 네 번째 실험은 explaination에 대한 실험입니다. 시각적으로 잘 설명이 되는지 평가하는 실험인데요. 이때 정성적, 정량적 평가로 나누어서 실험을 진행합니다.

1. Quantitative Evaluation

정량적 평가는 F1, NDCG를 이용해서 정량적 평가를 수행합니다. 이때에 Image 196개 region에서 correct하게 나오는지 확인합니다. 이때 region은 M개가 있으며 만약 이게 5개면 5개중 식별된 것이 있는가?를 따집니다.

2. Qualitative Evaluation

다음으로는 시각적 설명이 잘 나오는지 정성적 평가를 진행합니다. VECF(-rev)와 비교하였으며 그 결과로 VECF가 더 정확하다는 것을 보여줬습니다. 그러나 설명이 안 되는 것도 존재했다고 하네요.

Conclusions

마지막으로 본 추천 시스템 논문의 결론입니다.

결론

• Jointly leverage image region feature and user review information for enhancing fashion rec

• 더 좋은 성능을 이끌어 냈고 visual explanation도 가능함

마무리

이번 포스팅은 VECF : Personalized Fashion Recommendation with Visual Explanations based on Multimodal Attention Network 이라는 추천 시스템 논문을 리뷰하였습니다.

공부하시는 분들에게 조금이나마 도움이 되기실 바랍니다.

감사합니다.