포스팅 개요

이번 포스팅은 구글 코랩(google colab)에서 Ollama를 사용하는 방법에 대해서 정리합니다. 아무래도 요즘은 LLM을 활용해 RAG와 같은 다양한 애플리케이션 개발을 많이 수행하게 되는데요. 이때, 로컬에 LLM을 올려두어 사용하기도 하죠. 이때 많이 사용되는 것이 Ollama인데요. 이러한 Ollama를 colab에서도 사용할 수 있고, 최근에 개인적으로 해야할 상황이 있었습니다. 따라서, 이번 글은 코랩에서 ollama을 실행해서 LLM을 사용하는 방법에 대해서 정리해볼까 합니다.

포스팅 본문

구글 코랩은 무료로 GPU도 사용할 수 있고, 구글 드라이브 등에 데이터를 올려둔 상태로 파이썬(Python) 개발 등을 수행할 수 있는 매우 유용한 서비스인데요. 문제는 HuggingFace등에서 받은 오픈소스 LLM 등을 사용하기가 조금은 불편하다는 것입니다. 물론, 허깅페이스의 각 모델에 나와있는 예제 코드를 기반으로 사용해도 되긴합니다. 예를 들어, 아래 코드와 같이 말이죠.

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_id = 'Bllossom/llama-3.2-Korean-Bllossom-3B'

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

torch_dtype=torch.bfloat16,

device_map="auto",

)

instruction = "철수가 20개의 연필을 가지고 있었는데 영희가 절반을 가져가고 민수가 남은 5개를 가져갔으면 철수에게 남은 연필의 갯수는 몇개인가요?"

messages = [

{"role": "user", "content": f"{instruction}"}

]출처: https://huggingface.co/Bllossom/llama-3.2-Korean-Bllossom-3B

transformer 라이브러리의 AutoTokenizer, AutoModelForCausalLM 등을 사용해서 코랩 환경에서 실행할 수도 있습니다. 하지만, 아무래도 향후 확장성을 고려해서 Ollama와 같은 서비스를 이용해 LLM 모델을 띄어두고, API 형태로 호출하는 것이 더 유용하겠죠?

다행히도, colab에서도 Ollama를 활용해 LLM과 API 통신을 수행할 수 있습니다.

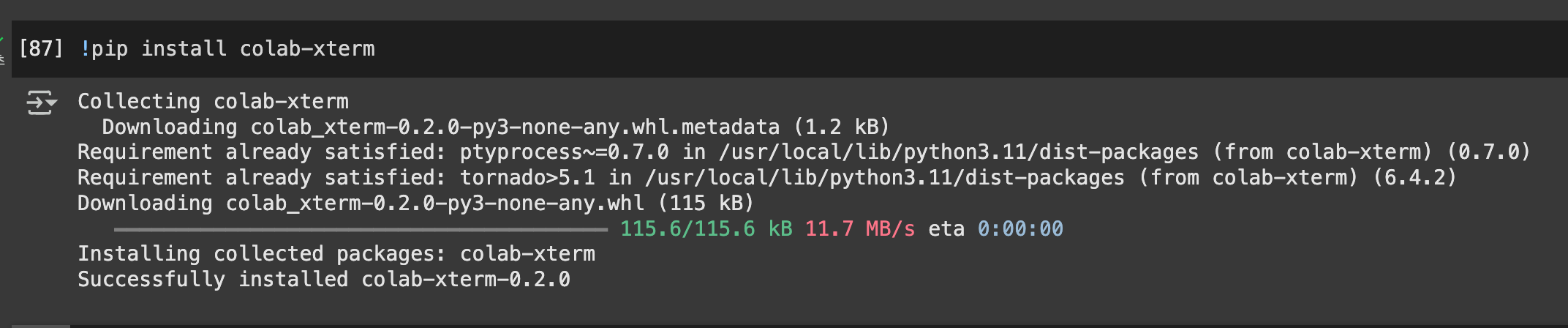

1. colab-xterm 설치 및 터미널 실행

가장 먼저, colab-xterm을 설치해줍니다. 이 라이브러리를 설치하면 colab 환경에서 터미널(terminal)을 사용할 수 있는데요. 다음과 같은 명령어로 쉽게 설치할 수 있습니다.

!pip install colab-xterm

위 명령어를 실행하면 정상적으로 설치가 되면서 successfully installed colab-xterm이 나오게 될 것입니다.

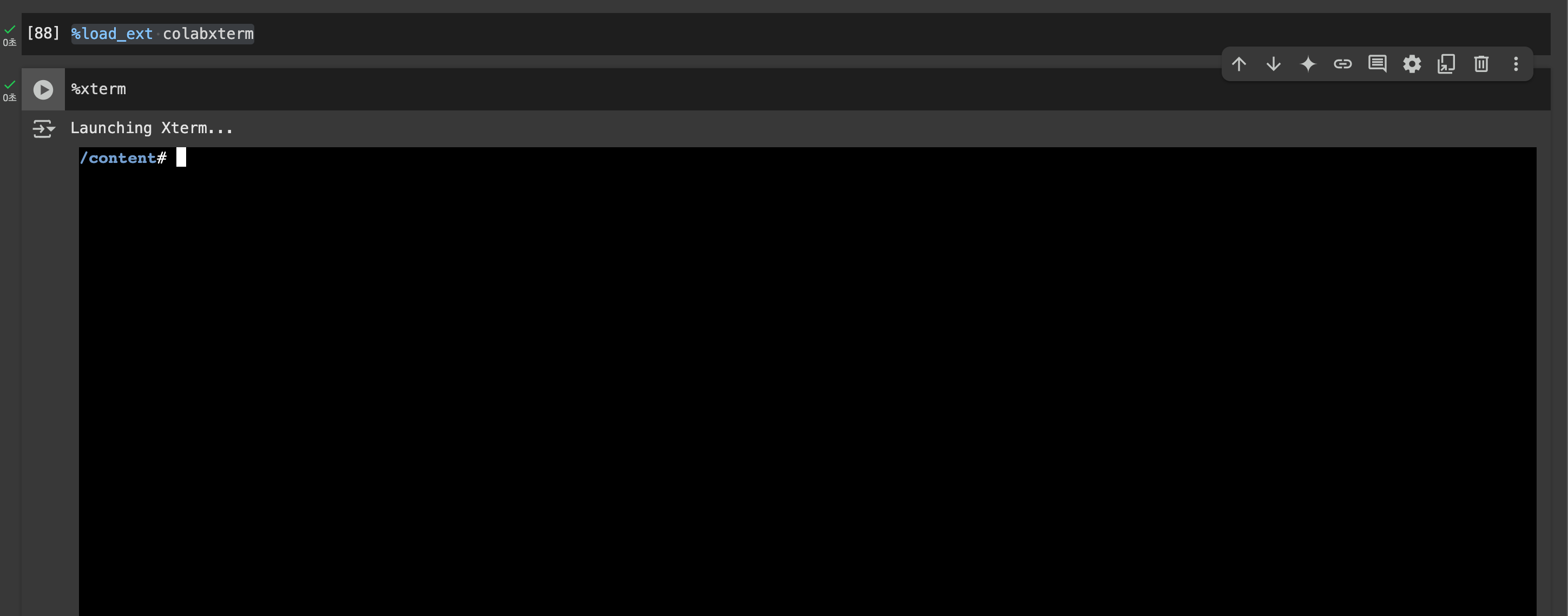

그러면 colab에서 터미널을 사용할 수 있는 준비가 되었는데요. 바로 실행해봅시다.

%load_ext colabxterm

%xterm

먼저, colabxterm을 load하고 %xterm 명령어로 실행하면 코랩 환경을 기준으로 terminal을 실행할 수 있게 됩니다.

여기서 기본적인 리눅스 명령어 등을 수행할 수 있는데요. 예를 들어, ll 명령어를 입력하면 아래와 같이 현재 디렉토리 경로의 리스트 결과가 나오게 됩니다.

2. Colab에 Ollama 설치

이제 이 상태에서 ollama를 설치합니다. 즉, colab의 터미널 환경을 활용해서 colab 환경에 ollama를 설치하는 것이죠. 다음과 같은 명령어를 입력합니다.

curl https://ollama.ai/install.sh | sh

ollama.ai의 install.sh을 curl 명령어로 설치하는 과정입니다. 한 1~2분 정도면 설치가 완료됩니다.

설치가 다 되면, 이제 ollama를 백그라운드에서도 동작되도록 명령어를 입력하면 되는데요.

여기서부터는 xterm을 이용하셔도 되고, 아니면 colab 셀에 "! 명령어"구로조 실행하셔도 됩니다.

여기서부터 colab의 xterm이 잘 수행이 안될 때가 있는데요.

위에까지는 잘 수행이 되는데, ollama를 실행시키는 것부터는 잘 안될 때가 있습니다.

이럴 때는 구글 코랩에서 !nohup 명령어로 ollama를 실행시키는 것을 추천드립니다.

ollama serve &

또는 colab 터미널에서

!nohup ollama serve > ollama.log &

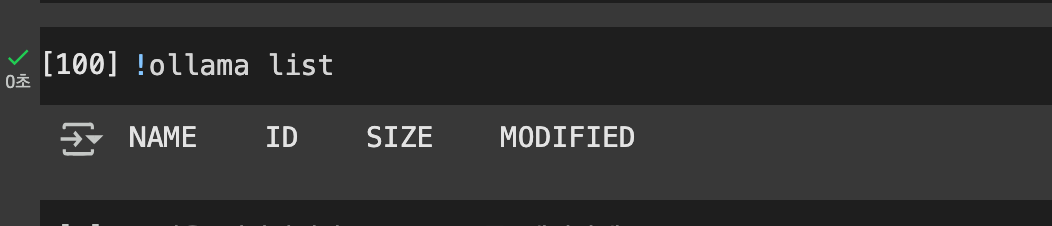

위와 같은 명령어를 실행하면 아래와 같이 ollama list 명령어를 입력했을 때 정상적으로 나오는 것을 확인할 수 있습니다.

(colab 코드 셀에서 !ollama list 를 입력하셔도 같은 결과를 볼 수 있습니다. xterm이 잘 안되시는 분들은 colab 셀에서 실행해주세요.(오른쪽 사진))

3. 원하는 LLM 모델 다운받기(feat. 허깅페이스(HuggingFace))

자, 아마 ollama list를 하면 아무것도 보이지 않을 겁니다. 왜냐하면, ollama에서 실행시킬 llm 모델을 셋팅하지 않았기 때문인데요.

이제 여러분들이 원하는 LLM 모델을 다운로드 받아서 활용하면 됩니다. 저는 허깅페이스(HuggingFace)에 올라와있는 모델 중 llama-3.2-Korean-Bllossom-3B-f16.gguf 모델을 사용하였습니다.

이때 모델은 wget과 같은 명령어로 쉽게 받을 수 있습니다.

!wget https://huggingface.co/bartowski/llama-3.2-Korean-Bllossom-3B-GGUF/resolve/main/llama-3.2-Korean-Bllossom-3B-f16.gguf -O /content/llama-3.2-Korean-Bllossom-3B-f16.gguf

이후, 여러분들이 받으신 모델에 맞는 Modelfile을 만드셔서 모델을 준비하시면 됩니다.

(만약, Ollama 설치나 모델 준비 등이 궁금하시다면 https://lsjsj92.tistory.com/666 글과 https://lsjsj92.tistory.com/685 글을 참고해주세요.)

Ollama 사용법 - 개인 로컬 환경에서 LLM 모델 실행 및 배포하기

포스팅 개요이번 포스팅은 대규모 언어 모델(Large Language Model, LLM)을 개인 로컬 환경에서 실행하고 배포하기 위한 Ollama 사용법을 정리하는 포스팅입니다. Ollama를 사용하면 유명한 모델들인 LLaMA

lsjsj92.tistory.com

Modelfile이 준비되었으면 ollama create -f를 통해 LLM 모델을 Ollama에 셋팅해줍시다.

!ollama create llama3.2-bllossom-3b-kr -f /content/Modelfile

이제 !ollama list를 통해 확인하면 Modelfile로 등록한 LLM 모델이 정상적으로 셋팅된 것을 확인할 수 있습니다.

4. Ollama API로 LLM과 통신 수행

자! 이제 코랩(colab)에 Ollama 설치도 완료했고, 허깅페이스에서 모델도 받아 Ollama에 셋팅도 완료하였습니다.

이제 실제로 동작이 되는 지 봐야겠죠?

먼저, colab 셀에서 아래와 같은 명령어로도 Ollama의 실행 결과를 간단하게 확인해볼 수 있습니다.

!ollama run llama3.2-bllossom-3b-kr:latest "안녕하세요?" 2> ollama.log

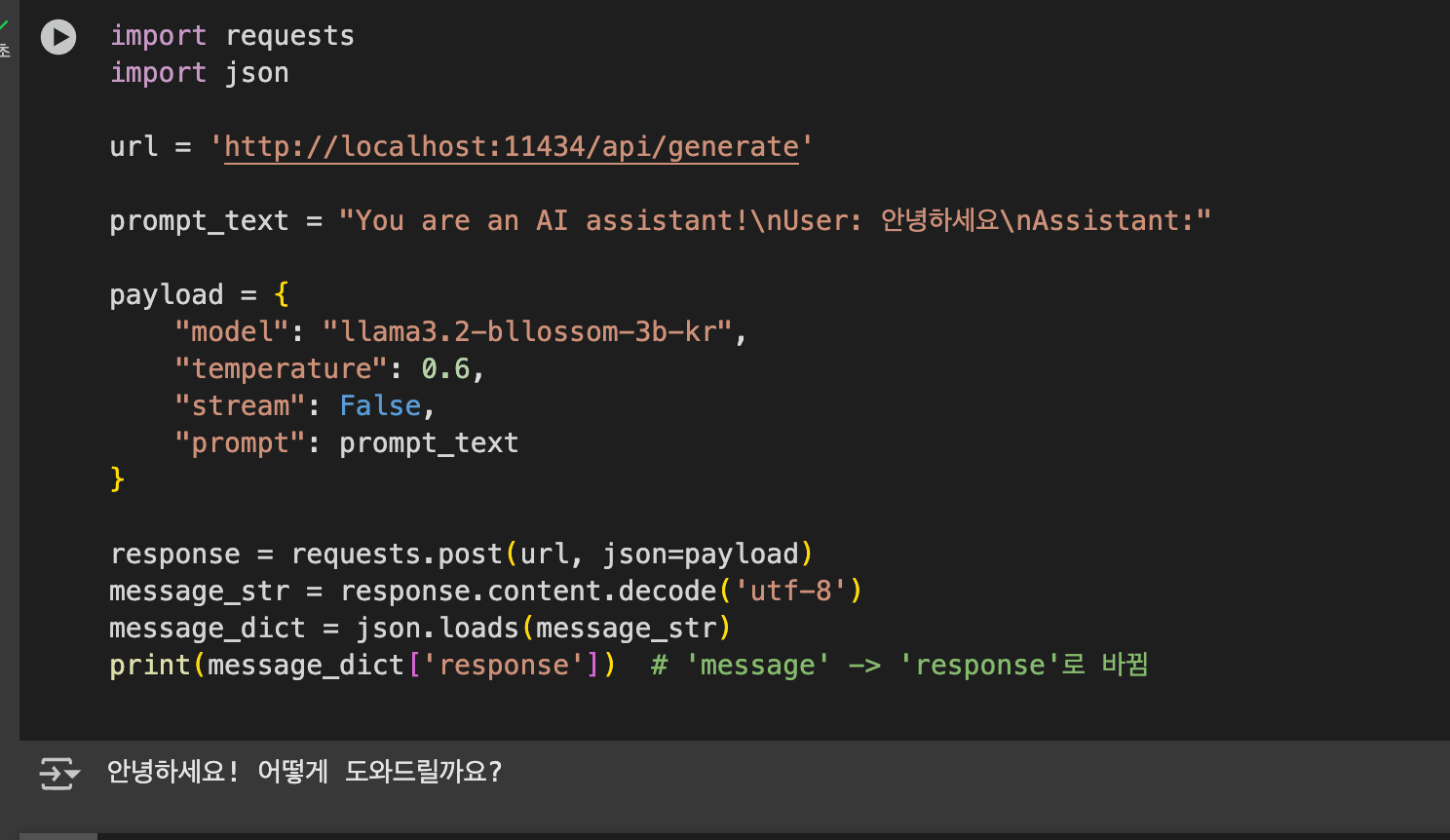

그리고, Python requests를 이용해 colab LLM과 API 통신할 수도 있습니다. 아래는 Ollama와 통신하는 파이썬 예제 코드입니다.

import requests

import json

url = 'http://localhost:11434/api/generate'

prompt_text = "You are an AI assistant!\nUser: 안녕하세요\nAssistant:"

payload = {

"model": "llama3.2-bllossom-3b-kr",

"temperature": 0.6,

"stream": False,

"prompt": prompt_text

}

response = requests.post(url, json=payload)

message_str = response.content.decode('utf-8')

message_dict = json.loads(message_str)

print(message_dict['response'])

그러면 위와 같이 실행이 되는 것을 확인할 수 있습니다.

마무리

이번 포스팅은 구글 코랩(google colab)에서 Ollama를 설치하고, LLM을 셋팅하여 API 통신을 통해 Ollama 환경의 LLM을 사용하고 실행하는 방법에 대해 알아보았습니다.

도움이 되시길 바랍니다.