목록데이터 (12)

꿈 많은 사람의 이야기

[9주차] 새벽 5시 캐글(kaggle) 필사하기 - 자연어처리(nlp) toxic 데이터 Attention

[9주차] 새벽 5시 캐글(kaggle) 필사하기 - 자연어처리(nlp) toxic 데이터 Attention

이전에 캐글(kaggle) nlp인 toxic 데이터를 가지고 필사를 했습니다https://lsjsj92.tistory.com/448 이번에도 마찬가지로 toxic 데이터를 가지고 캐글 커널을 필사합니다.기존에 했던 것과 같습니다. 하지만 어텐션 메커니즘이 추가된 코드이고 glove 데이터를 이용해서 모델 weight를 제공해줍니다.특히 glove 데이터를 추가해서 word embedding을 하는 방법은 정말 많이 사용해서 이번 기회에 정리하고자 합니다. 언제나 그렇듯이 필요한 라이브러리르 불러옵니다keras를 사용했고 모델과 전처리에 필요한 Tokenizer 및 LSTM, Embedding, Dropout 등을 가지고 옵니다그리고 이번 모델에서는 Attention을 class로 만들어서 사용하기 때문..

파이썬(python)으로 SNS 텍스트 데이터 분석하기(python word2vec, python 크롤링)

파이썬(python)으로 SNS 텍스트 데이터 분석하기(python word2vec, python 크롤링)

벌써 이것을 진행한지는 꽤 되었지만 이 블로그에는 올리지 않아서 다시 올립니다~원본 게시글은https://post.naver.com/viewer/postView.nhn?volumeNo=16628864&memberNo=34022432 여기에 올려져 있습니다~파이썬으로 텍스트 데이터를 분석하는 작업인데 소셜 네트워크 서비스(SNS) 데이터를 활용합니다 타겟 데이터는 비트코인, 이더리움 등의 암호화폐(가상화폐)로 유명한 오픈 커뮤니티인 코인판(coinpan)을 활용합니다코인판에서 나온 메디블록(mediblock) 게시글을 분석해서 메디블록과 관련된 텍스트 데이터를 분석해보려고 합니다!참고로 이 분석은 벌써 시간이 반년정도 되었습니다.지금과는 이슈가 다를 것입니다.약올림이라는 어플이 나왔을 때 했던 프로젝트고본..

[3주차] 새벽 5시 캐글(kaggle) 필사하기 - porto 데이터 편 - 1

[3주차] 새벽 5시 캐글(kaggle) 필사하기 - porto 데이터 편 - 1

안녕하세요.새벽 5시 캐글 필사하기 3주차입니다.사실 캐글 필사는 계속 하고 있는데 블로그에 올리기가 너무 힘드네요요즘 바빠서 퇴근 시간이 늦다 보니(집오면 10시 ㅠ) 블로그에 올릴 시간이 없네요 ㅠ 3주차 주제는 porto 데이터 셋으로 진행합니다. 안전하게 운전을 하는 운전자를 예측하는 데이터입니다.데이터는 https://www.kaggle.com/c/porto-seguro-safe-driver-prediction 에 있습니다. 이번 주제도 1, 2주차에 걸쳐서 진행합니다. 1주차는 먼저 머신러닝 탐구생활이라는 책의 EDA 과정을 볼 것이고, 좀 이해하기 힘든 커널을 1개 필사했습니다.(아직도 이해가 안갑니다…) 시작해봅니다! 머신러닝 탐구생활 책을 기준으로 진행합니다. 역시 데이터부터 살펴보기 위..

캐글을 하면서 겪은 이슈들(kernel stopping, timeout error)

캐글을 하면서 겪은 이슈들(kernel stopping, timeout error)

최근 캐글을 자주하고 있습니다.(새벽 5시 시리즈를 올려야하는데.. 블로그 글 쓸 시간이 만만치 않아서 못올리고 있습니다 ㅠ)근데 캐글을 하면서 알 수 없는 에러를 자주 겪었습니다.그것에 대해서 몇 개 정리해보려고 합니다. 먼저 아래와 같은 사진 이슈입니다. timeout waiting for IOPub output 이라는 warning이 나옵니다.음 그렇게 치명적인 오류는 아닌 것 같은데요. 저는 이게 나오면서 커널이 멈추는 현상이 나왔습니다(kernel stopping)알고보니 이게 모델을 훈련 하는 등의 과정에서 output이 나오는데요.예를 들어 verbose값이 1이거나 이런 상황에서요. 이런 출력이 좀 무리?가 되는 것이 있나봅니다.verbose = 0으로 하면 별 문제없이 해결됩니다. 그리고..

[1주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉(titanic) 편

[1주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉(titanic) 편

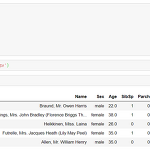

새해 첫 목표를 두고 있는 새벽 5시 캐글 필사 편 1주차 내용이다. 사실 원래 다른 데이터로 진행하려고 했는데 어쩌다 보니 타이타닉으로 넘어왔다. 머신러닝 탐구생활이라는 책으로 시작하려고 했지만 쉽지 않았기 때문이다. 또한, 데이터 분석을 한동안 안했더니 감을 잃은 것도 컸다. 그리고 마침 페이스북 그룹인 캐글 코리아(kaggle korea)에서 대회를 타이타닉을 주제로 하고 있기에 타이타닉으로 진행했다. 이 과정에서 1주일이 날라갔다 ㅠ 그래서 타이타닉 편으로 시작! 이 필사는 다양한 커널을 참조했다. 타이타닉 커널을 보면 open되어 있는 커널 중 인기 많은 커널 2개와 약간의 내 아이디어? 를 짬뽕시켜서 진행했다. 많이 참조한 대표적인 커널은 https://www.kaggle.com/ash316/..

파이썬으로 데이터 분석하기 - 어느 주유소가 기름값이 저렴할까? 주유소 기름값 분석하기!

파이썬으로 데이터 분석하기 - 어느 주유소가 기름값이 저렴할까? 주유소 기름값 분석하기!

올만에 올리는 파이썬 데이터 분석글입니다.이번 파이썬 데이터 분석글은 주유소 데이터를 분석하는 것 입니다!요즘 기름값이 많이 싸졌죠?기름값이 저렴해진 이후로 서울 각 구 마다 어디가 저렴한지를 분석해봤습니다.그리고 셀프 주유일 떄와 아닐 때와 가격 차이도 봐보겠습니다~ 저는 데이터를 opinet에서 가져왔습니다.이 사이트는 저렴한 주유소를 잘 소개한 사이트입니다.그렇기 때문에 모든 주유소 데이터는 존재하지 않습니다.가령 많이 비싸거나 등등 데이터는 없더라구요하지만 사람들은 저렴한 기름값(휘발유나 경유 등)을 원하니까요 ㅎㅎ 이런 사이트인데요저렇게 서울시 예를 들어 강남구, 서초구, 노원구, 도봉구 등을 선택하면주유소를 추천해주면서 휘발유와 경유의 값을 보여줍니다.그리고 무엇보다! 엑셀로 받을 수 있습니다..

파이썬에서 구글맵 사용해보기!(feat. folium)

파이썬에서 구글맵 사용해보기!(feat. folium)

파이썬은 아무래도 데이터 분석에 강화되어 있다보니까 지도와 관련된 api도 있다.그 중 많이 사용하는 것 중 하나가 구글맵이다.이번 포스팅은 파이썬에서 구글맵을 사용하는 방법을 알아보고자 한다. 지금 구글맵은 기존 구글맵스 API가 아닌 구글맵스플랫폼 단일 브랜드로 통합되었다. 관련 기사이다.https://cloud.google.com/maps-platform/에 들어가서 해야한다. 먼저 그 전에 프로젝트를 생성하자. https://cloud.google.com/maps-platform/?apis=maps여기서 프로젝트를 생성하고 처음 링크에서 진행한다. pick a product에서 원하는 상품을 선택하고project를 선택한다.본인은 soojinPython이라는 이름으로 프로젝트를 만들어두었다. 그리..

파이썬 판다스(pandas) 에러 해결하기

파이썬 판다스(pandas) 에러 해결하기

꽤나 오래전에 겪었던 에러인데..이제서야 올려본다 파이썬 라이브러리중 판다스(pandas)를 사용하다보면 가끔 이런 에러를 겪는다. Error Tokenizing data. C error : EOF inside string starting at line ~~ 이라는 에러이다. 본인은 이걸 pandas read_csv 등을 할 때 겪었었는데 아무리해도 해결방법을 찾지 못했었다. 그러다가 찾은 해결 방법.. 그냥 새롭게 파일을 만든다. 외부에서 만드는게 아니라 파이썬 내부 코드로 csv 파일을 읽고 그대로 다시 dataframe을 짜서 그걸 다시 csv로 똑같이 저장한다.그러면 이상하게 잘 된다. 혹시 모르니까 파일을 읽을 때 공백 제거해주는 strip을 쓰면 좋다.

도커 docker compose를 이용한 ELK 스택 설치해보기

도커 docker compose를 이용한 ELK 스택 설치해보기

이번에는 도커의 가장 강력한 기능중 하나인 docker compose에 대해서 알아보고 이걸 이용해서 빅데이터 분석 도구로 사용되고 있는 Elasticsearch-Logstash-Kibana(ELK)를 설치해보겠습니다. 먼저 도커 컴포즈(docker compose)에 대해서 알아봐야겠죠?복수개의 컨테이너가 하나의 애플리케이션으로 구동되는 경우 컨테이너 조합이 복잡해지기 쉽습니다. 예를 들어서 웹 애플리케이션을 하나 구축하려고 하면 web 서버 컨테이너 + WAS 서버 컨테이너 + DB 컨테이너 등을 생성해야하죠.근데 이걸 하나하나 run 시킨다?? 이건 너무 불편하죠.그래서 docker compose가 나옵니다. 도커 컴포즈는 여러개의 컨테이너를 개별 서비스로 인지하게 해서 컨테이너 묶음으로 관리하게 해..

ELK 스택 설치 - 엘라스틱서치(elasticsearch) 설치하기

ELK 스택 설치 - 엘라스틱서치(elasticsearch) 설치하기

ELK는 Elasticsearch, Logstash, Kibana로 구성된 데이터 분석을 할 수 있는 오픈소스 데이터 시각화입니다각 요소가 하는 역할을 간단히 살펴보면Elasticsearch : 데이터 처리/검색엔진 => 일종의 DBLogstash : 실시간 데이터 파이프라인을 통하여 데이터 수집Kibana : 시각화 로 구성되어 있습니다. 이번 포스팅은 이 중 엘라스틱 서치를 설치하도록 하겠습니다.elasticsearch와 logstash, kibana는 각각 다른 서버에 구축할 것입니다.즉 3대의 서버에 따로따로 설치하려고 합니다. 어차피 설정에서 ip 주소등을 설정해주면 되니까요! 먼저 엘라스틱 서치를 설치해보죠.조건! java가 설치되어 있어야 합니다.https://lsjsj92.tistory.c..