목록Titanic (3)

꿈 많은 사람의 이야기

kubeflow pipeline AWS와 연동하기 - kubeflow pipeline example with titanic data

kubeflow pipeline AWS와 연동하기 - kubeflow pipeline example with titanic data

포스팅 개요 이번 포스팅은 지난 글(kubeflow pipeline iris data)에 이어 kubeflow 예제(kubeflow example)에 대해서 작성합니다. 지난 글은 kubeflow 설치하는 방법과 kubeflow를 간단하게 사용할 수 있는 방법에 대해서 알아보았는데요. 이번 포스팅은 kubeflow 예제를 타이타닉(titanic data)데이터와 함께 예제를 작성합니다. 특히, AWS 서비스들과 연동하여 머신러닝 파이프라인(machine learning pipeline)을 구축해 보려고 합니다. 지난 포스팅은 아래 링크이므로 혹시 kubeflow가 설치되어 있지 않거나, 간단한 kubeflow 예제를 보고 싶으신 분들은 참조하시길 바랍니다. kubeflow 설치 : https://lsjs..

[2주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉 편_2

[2주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉 편_2

어느덧 새벽 5시 캐글(kaggle) 2주차이다!지난 게시글에서 타이타닉(titanic) 캐글 커널을 필사했었다하지만 결과는 그리 좋지 못했었는데 오늘은 그것을 보완하는 작업을 한다 이번 필사 작업의 참조 커널은 https://www.kaggle.com/yassineghouzam/titanic-top-4-with-ensemble-modeling/notebook 에서 참고하였다! 이것을 필사? 참고 후 현재 나의 캐글 상태이다.캐글 코리아에서 주최한 2019 1st ML month with KaKR 대회 성적은 별로지만밑에 titanic : machine learning 부분의 대회는 상위 6% 성적을 보였다. 이 글은 주로 seaborn의 factorplot을 자주 이용했다.factorplot을 사용하면..

[1주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉(titanic) 편

[1주차] 새벽 5시 캐글(kaggle) 필사하기 - 타이타닉(titanic) 편

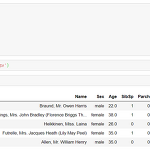

새해 첫 목표를 두고 있는 새벽 5시 캐글 필사 편 1주차 내용이다. 사실 원래 다른 데이터로 진행하려고 했는데 어쩌다 보니 타이타닉으로 넘어왔다. 머신러닝 탐구생활이라는 책으로 시작하려고 했지만 쉽지 않았기 때문이다. 또한, 데이터 분석을 한동안 안했더니 감을 잃은 것도 컸다. 그리고 마침 페이스북 그룹인 캐글 코리아(kaggle korea)에서 대회를 타이타닉을 주제로 하고 있기에 타이타닉으로 진행했다. 이 과정에서 1주일이 날라갔다 ㅠ 그래서 타이타닉 편으로 시작! 이 필사는 다양한 커널을 참조했다. 타이타닉 커널을 보면 open되어 있는 커널 중 인기 많은 커널 2개와 약간의 내 아이디어? 를 짬뽕시켜서 진행했다. 많이 참조한 대표적인 커널은 https://www.kaggle.com/ash316/..