목록NMT (4)

꿈 많은 사람의 이야기

기계 번역에 어텐션 메커니즘 적용하기 - 딥러닝 자연어처리 공부

기계 번역에 어텐션 메커니즘 적용하기 - 딥러닝 자연어처리 공부

지난 포스팅에 seq2seq 모델을 적용시켜서 기계 번역에 대해서 알아보았습니다. 인공지능 기반 자연어 처리 번역 즉, 기계 번역(NMT)은 규칙 기반부터 확률, 통계 기반으로 시작하여 현재 딥러닝을 활용해 기계 번역을 하는 역사를 가지고 있다는 것도 배웠죠 또한, 그 중심에 seq2seq 모델이 있다는 것도 배웠습니다. 하지만 seq2seq는 한계가 있습니다. 그 한계는 바로 번역이 잘 되지 않는다는 것이죠 그래서 어텐션 메커니즘이 나오게 됩니다. Attention Mechanism은 무언가에 집중한다는 개념입니다. 이 어텐션 메커니즘의 효과는 정말 어마어마합니다. 현재 자연어처리 분야에 있어서 어텐션 메커니즘을 안쓰는 곳이 없기 때문이죠. 또한 인공지능, 딥러닝 분야에서도 핫한 기술이기도 합니다. 이..

딥러닝 자연어처리 이해하기! - 기계번역편(NMT), seq2seq란?

딥러닝 자연어처리 이해하기! - 기계번역편(NMT), seq2seq란?

딥러닝이 핫한 지금 영상처리 분야뿐 아니라 자연어 처리 분야도 엄청 핫합니다. 특히 일반적인 문서 분류(text classification)를 넘어서 이제 번역기나 문장 생성, 텍스트 생성에도 포커스가 맞춰지고 있죠 이번 포스팅은 seq2seq에 대해서 자세히 알아보려고 합니다. 제 블로그에 seq2seq 내용을 다루긴 했지만 이론적인 내용이 부실했었습니다. 그래서 최근 제가 모두의 연구소에서 자연어처리 기초반(NLP)을 운영하면서 진행했던 발표 자료를 가지고 다시 정리해보려고 합니다. 기계 번역의 역사부터 현재까지 어떻게 진행되는지 전반적인 내용을 보려고 합니다. 그리고 이 자료는 허훈님의 자료를 조금 참고해서 만들었었습니다. 그럼 시작하죠! 먼저 기계 번역의 역사입니다. 기계 번역의 역사는 사실 좀 ..

어텐션 메커니즘(Attention Mechanism)이란? 어텐션에 대해서

어텐션 메커니즘(Attention Mechanism)이란? 어텐션에 대해서

자연어 처리에서 공부를 하다보면 어텐션 메커니즘에 대해서 많이 듣게 됩니다아무래도 구글에서 발표한 attention is all you need의 transformer에서도self-attention(셀프 어텐션)을 사용하고기존의 LSTM(RNN)과 seq2seq 문제를 극복하기 위해서 많이 사용되기 때문에 계속 듣게 됩니다 어텐션(attention)에 대해서 공부를 하려면 먼저 저 메커니즘에 대해서 알아야겠죠그래서 이번 포스팅은 어텐션 메커니즘(attention machanism)에 대해서 정리합니다. 어텐션은 영상 처리쪽에서도 많이 사용됩니다.아마 CS231n 강의 같은 것을 보셨으면 아래 사진을 보셨을 겁니다. 대충 느낌 오시죠? 이것은 인간의 시각적 집중(visual attention) 현상을 구현..

딥러닝을 활용한 번역기를 만들어보자!(python keras seq2seq translate model)

딥러닝을 활용한 번역기를 만들어보자!(python keras seq2seq translate model)

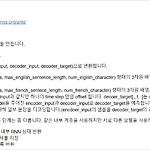

어제 텐서플로와 머신러닝으로 시작하는 자연어 처리 책을 보면서 sequence-to-sequence 모델을 공부했습니다.챗봇을 만들 때 사용하던 모델이었는데 과연 케라스(keras)에서는 어떻게 사용되는지 궁금해서 공부를 했고지금 정리를 하려고 합니다. 이 자료는 케라스 코리아 운영자이신 김태영님의 블로그를 많이 참고했습니다!https://tykimos.github.io/2018/09/14/ten-minute_introduction_to_sequence-to-sequence_learning_in_Keras/ 기계번역(NMT, Neural Machine Translation)에서 많이 쓰이는 seq2seq 모델은 작성된 소스 문장들(source sentences)을 인코더(Encoder)를 이용해서 생각 ..